LLMs之RAG:只需四步骤—基于Ollama后端框架(配置phi3/LLaMA-3模型)结合Dify前端框架(设置知识库文件+向量化存储+应用发布)创建包括实现本地知识库问答/翻译助手等多个应用

LLMs之RAG:基于Ollama后端框架(配置phi3/LLaMA-3模型)结合Dify前端框架(设置知识库文件+向量化存储+应用发布)创建包括实现本地知识库问答/翻译助手等多个应用

目录

基于Ollama后端框架(配置phi3/LLaMA-3模型)结合Dify前端框架(设置知识库文件+向量化存储+应用发布)创建包括实现本地知识库问答/翻译助手等多个应用

1、配置依赖

1.1、安装Docker和Docker Compose,

1.2、安装并配置Ollama

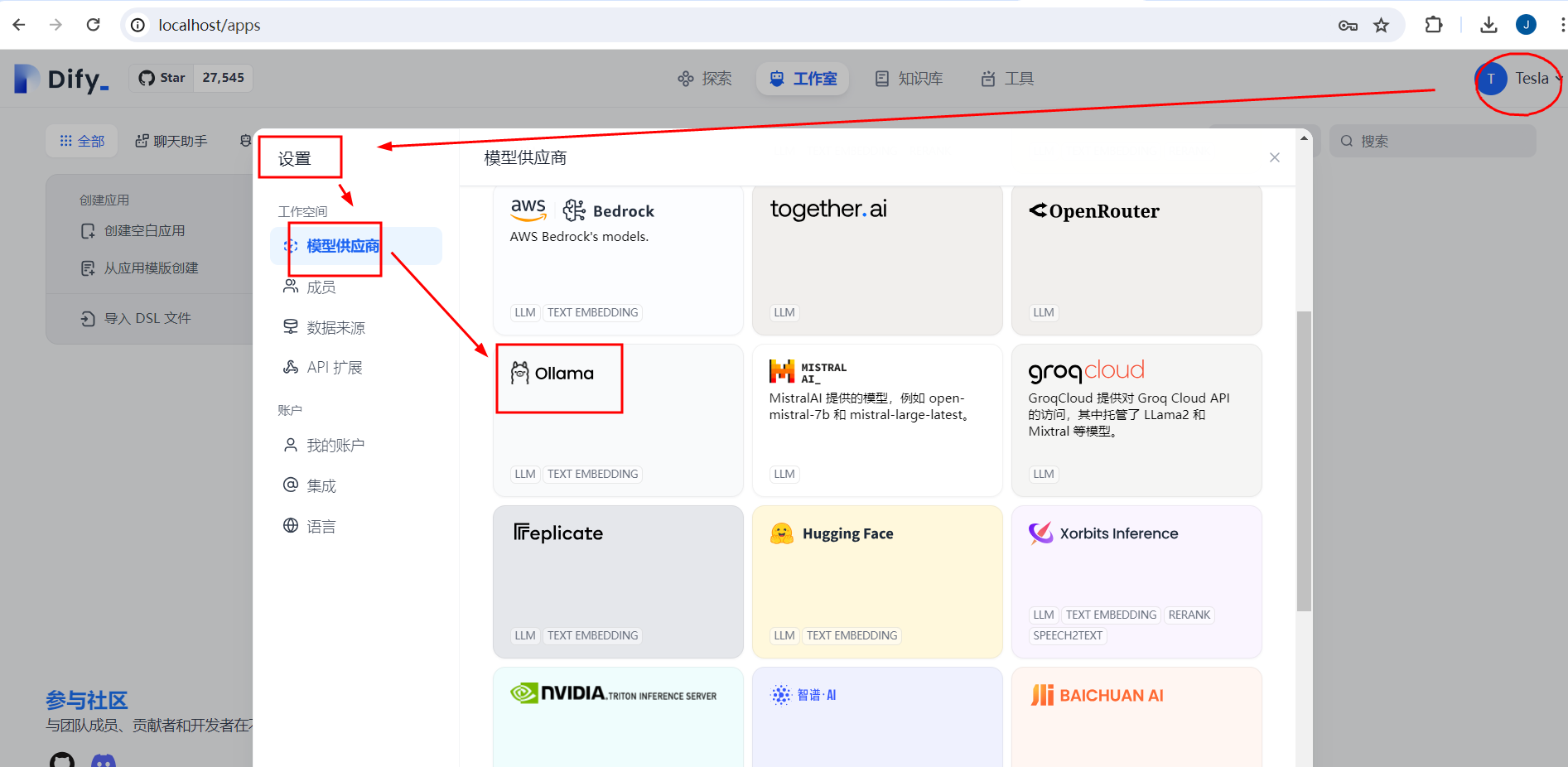

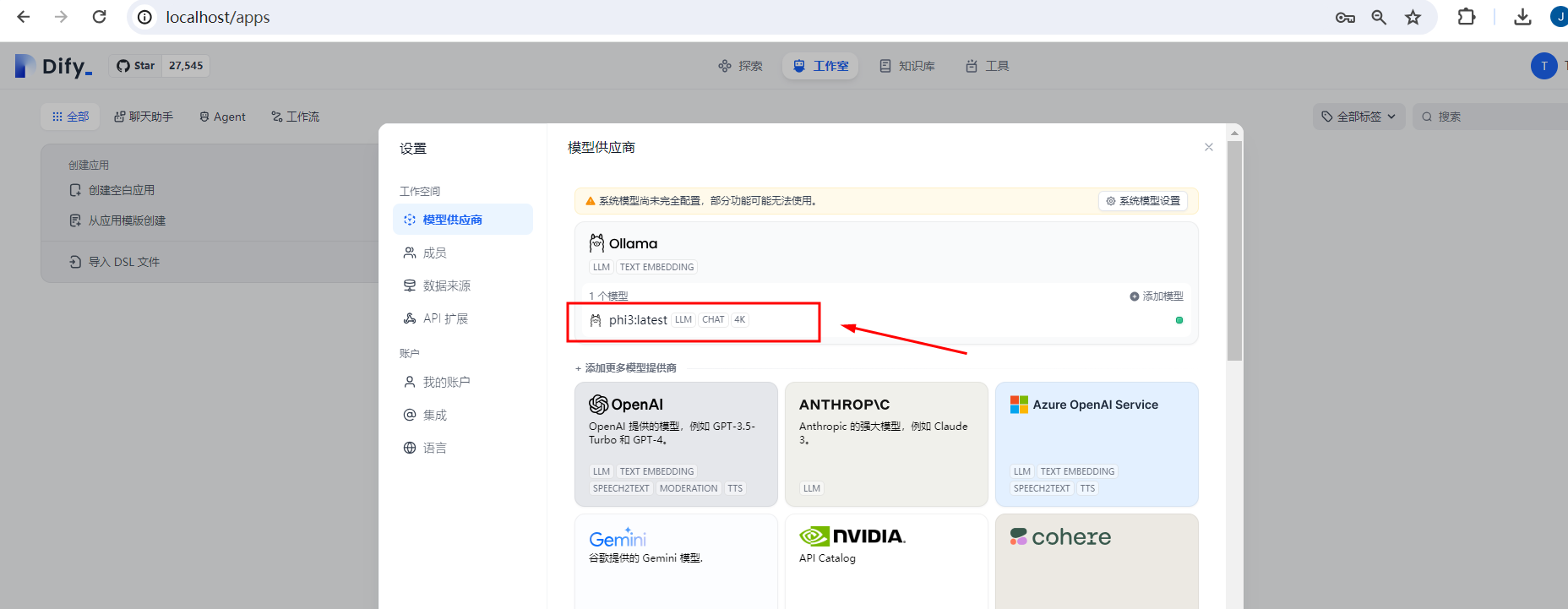

1.3、打开Dify界面并配置模型

2、创建模型基于RAG的对话应用

2.1、配置模型

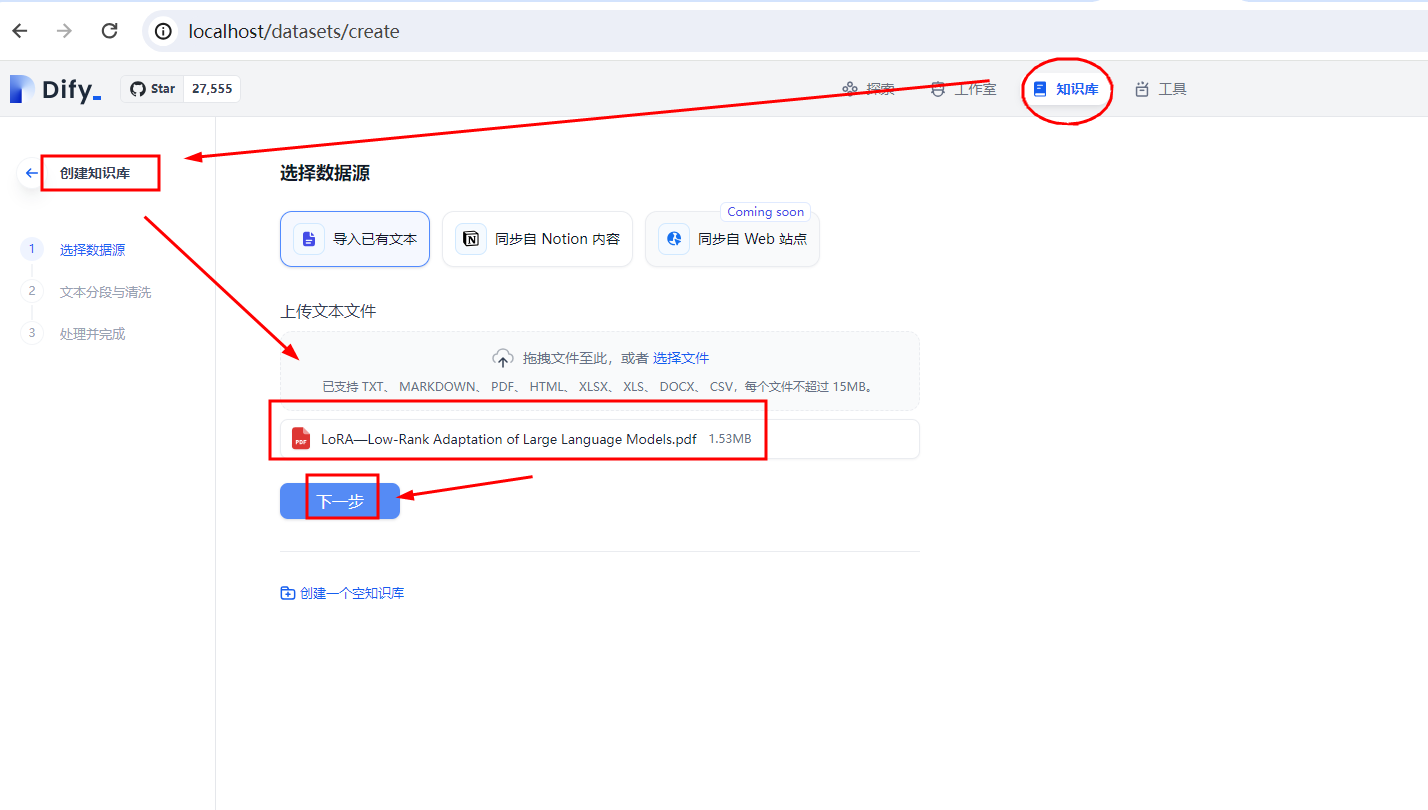

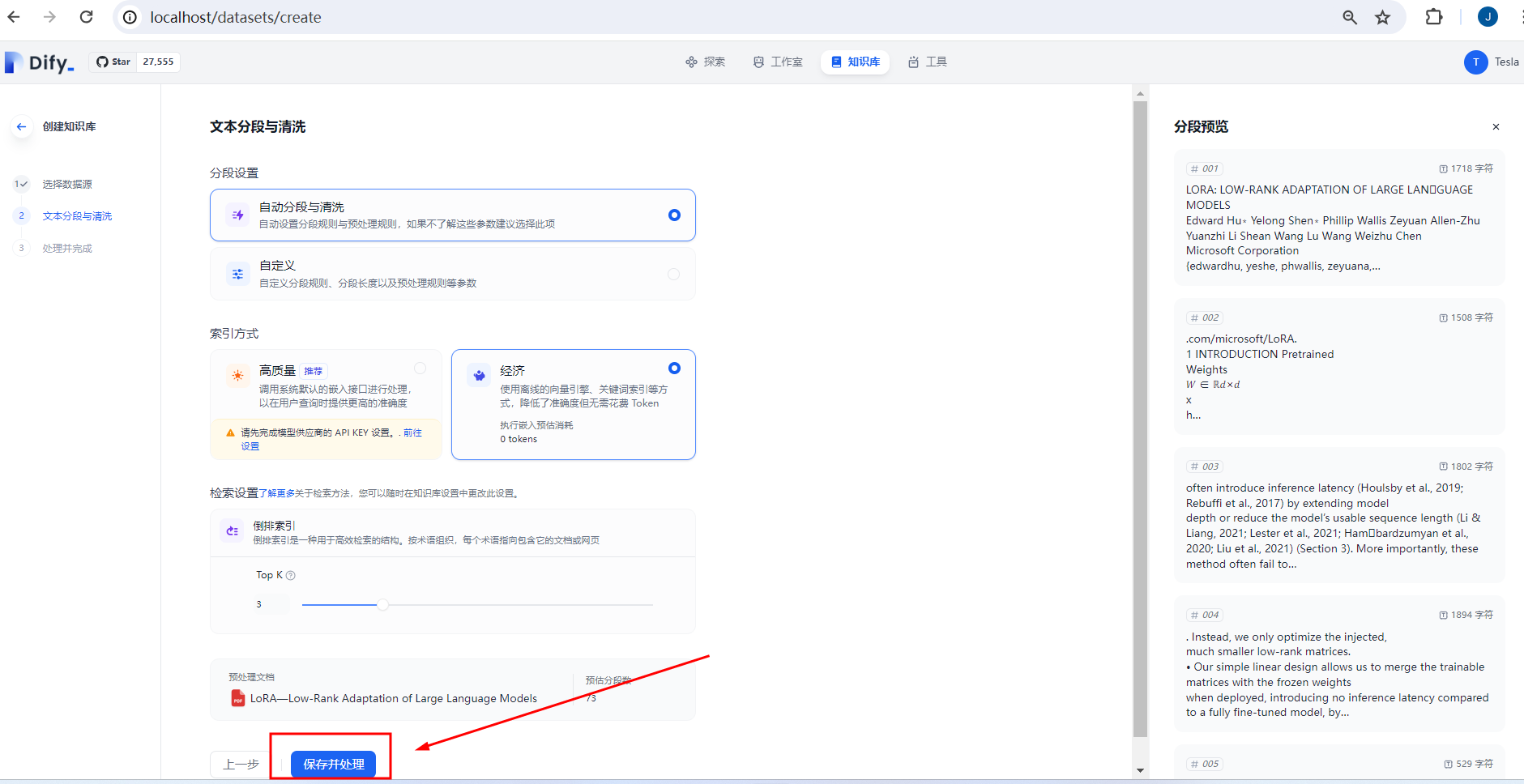

2.2、创建知识库并向量化存储

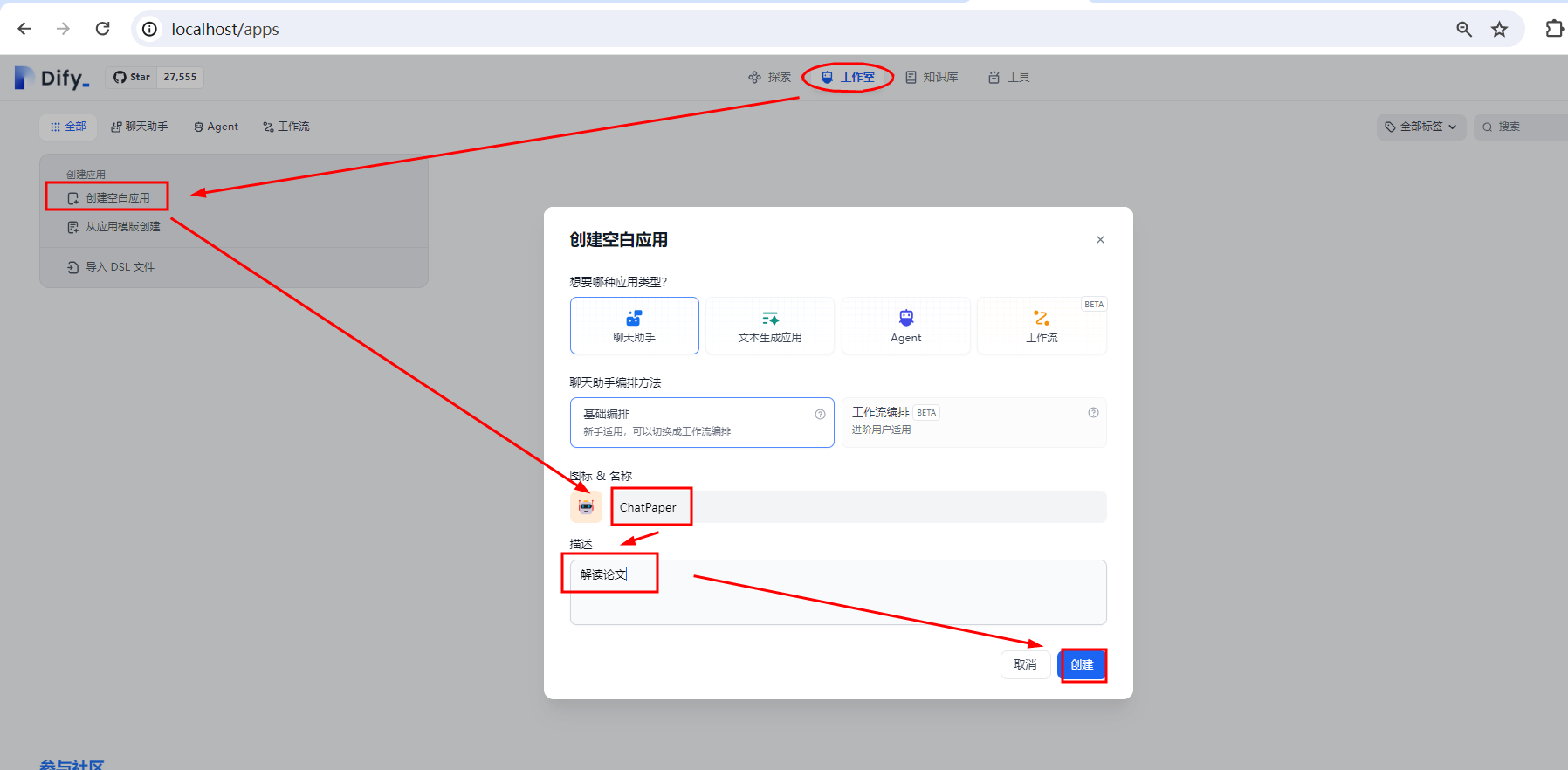

2.3、创建应用并发布

2.4、基于知识库进行对话测试

基于Ollama后端框架(配置phi3/LLaMA-3模型)结合Dify前端框架(设置知识库文件+向量化存储+应用发布)创建包括实现本地知识库问答/翻译助手等多个应用

1、配置依赖

1.1、安装Docker和Docker Compose,

安装 | 安装Docker和Docker Compose 参考A3、Windows11系统安装→交互式安装即可,一次性安装Docker和Docker Compose 地址:Docker:Docker的简介、安装、使用方法之详细攻略_docker 知乎-CSDN博客 |

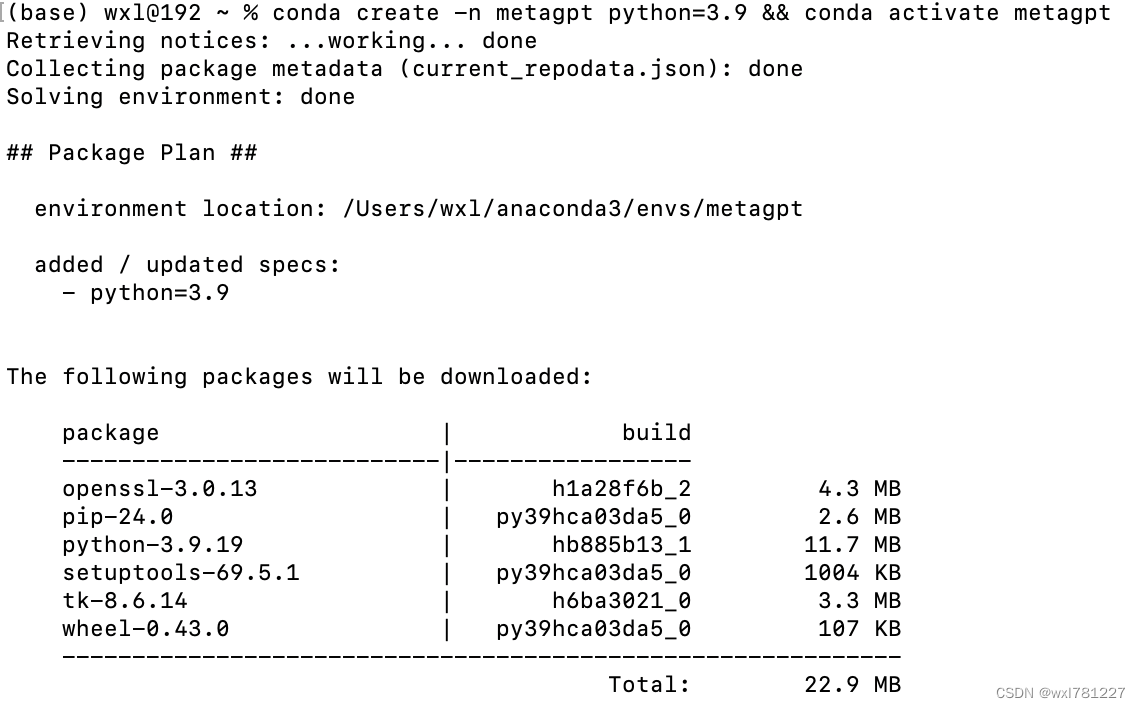

1.2、安装并配置Ollama

安装并配置Ollama | 安装并配置Ollama参考 地址:LLM之Ollama:ollama的简介、安装和使用方法、案例应用之详细攻略_ollama中文说明书-CSDN博客 地址02:http://yunyaniu.blog.csdn.net/article/details/138235781 |

1.3、打开Dify界面并配置模型

安装并启动Dify | 参考——1、Dify的安装和启动 地址:LLMs之Dify:Dify的简介、安装和使用方法、案例应用之详细攻略-CSDN博客 |

打开界面 | 浏览器中访问http://localhost/install并开始初始化过程,设置账号,之后用此账号登录。 地址:http://localhost/install |

2、创建模型基于RAG的对话应用

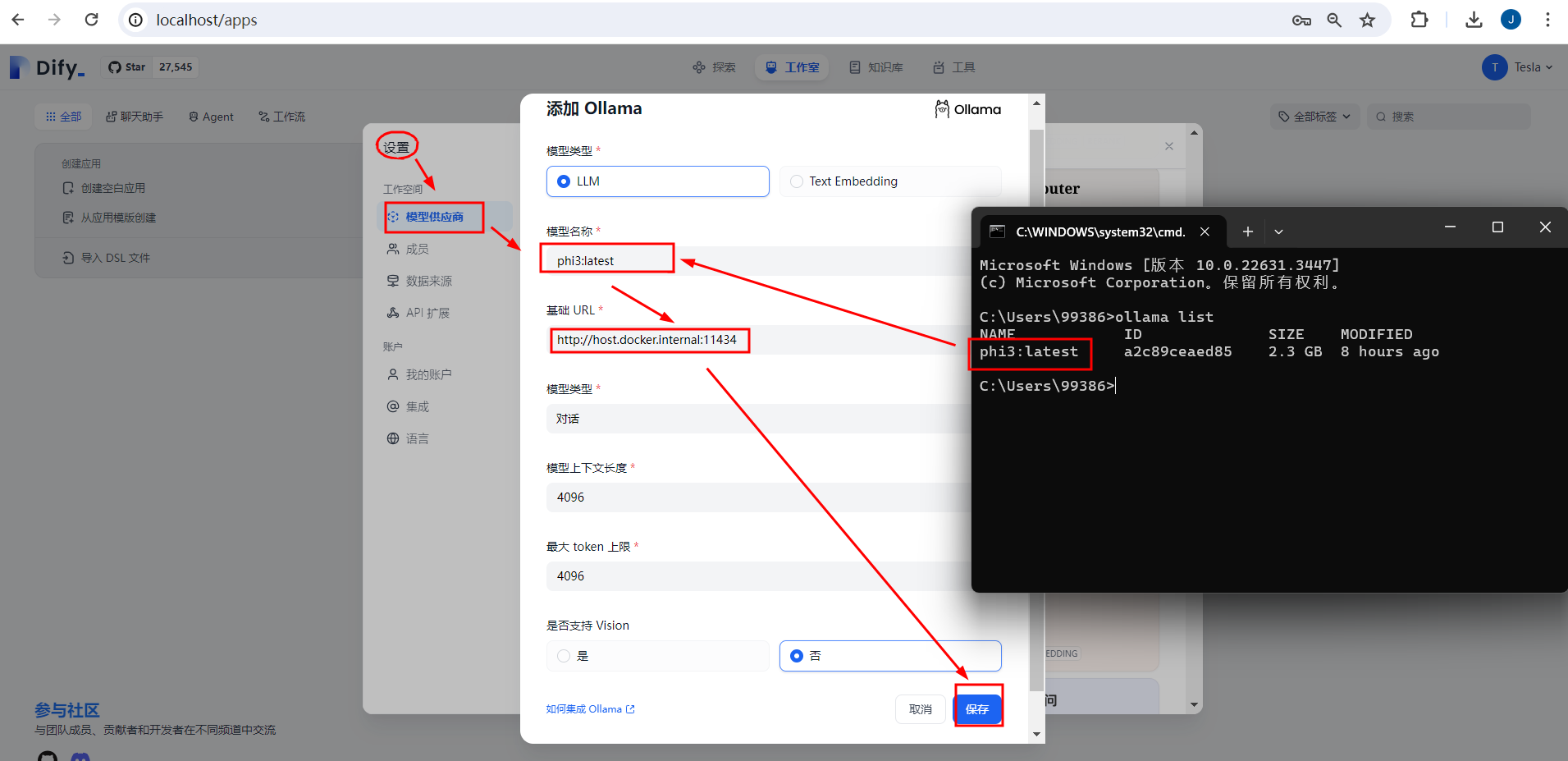

2.1、配置模型

配置模型 | 模型名称:phi3:latest 容器地址:http://host.docker.internal:11434 |

2.2、创建知识库并向量化存储

点击知识库→创建知识库→添加PDF资料→保存并处理

2.3、创建应用并发布

创建应用→设置角色→添加知识库资料→并设置提示词→选择大语言模型→依次点击更新→发布→Start Chat即可!

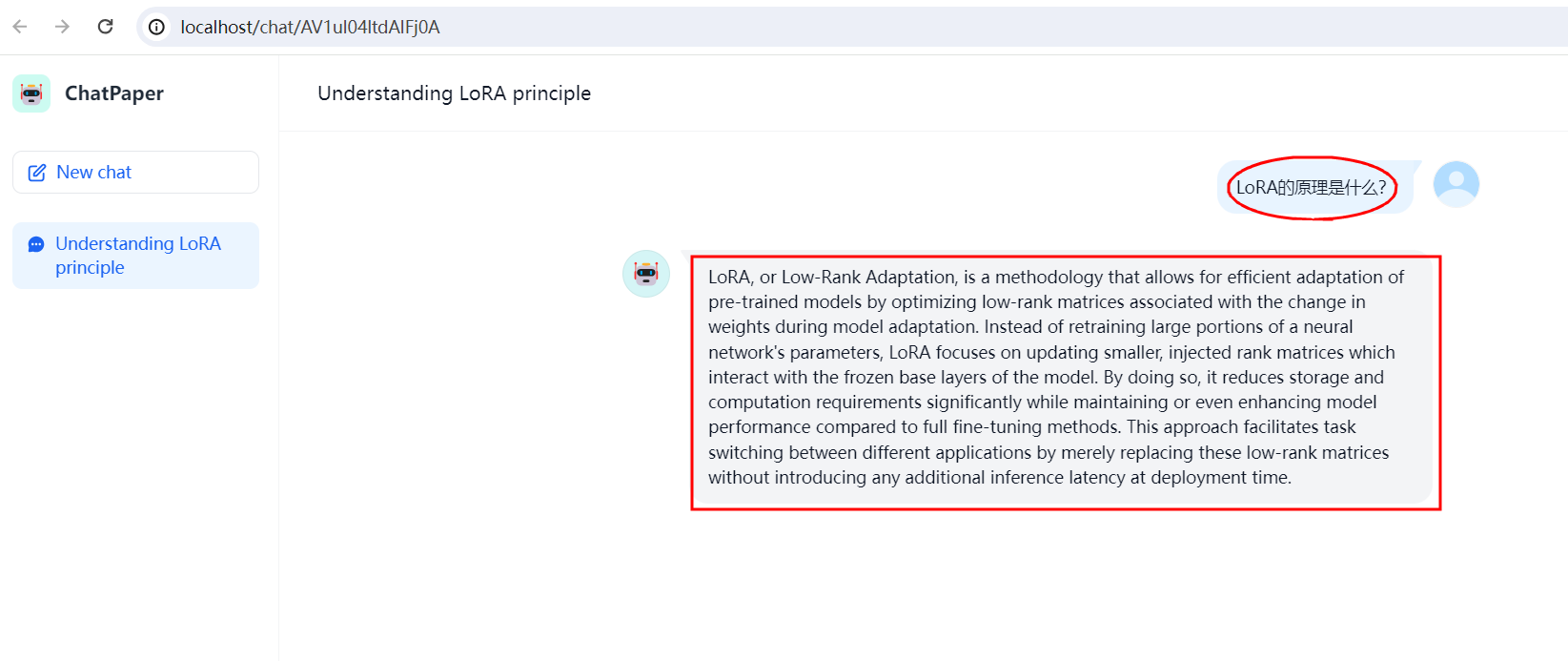

2.4、基于知识库进行对话测试