均值漂移算法(Mean Shift)【python,机器学习,算法】

均值偏移(Mean shift)算法是在特征空间中应用核密度估计的爬山算法,其算法思想是假设不同簇类的数据集符合不同的概率密度分布,找到任一样本点密度增大的最快方向(可以通过Mean shift计算得到),样本密度高的区域对应该簇类的中心所在,这样样本点最终会在局部密度最大处收敛,且收敛到相同的局部最大值的样本点被认为是同一簇类的成员。Mean shift 算法可用于聚类、图像分割、跟踪等。

均值偏移算法的一般步骤为:

- 对于每一个数据点进行质心偏移计算。

- 先假设数据点为质心,以当前质心为圆心,在半径为 R 的圆内,找出所有的样本数据点,并计算这些点的特征值的平均值,平均值即为该区域内的新质心。

- 如果新的质心与旧的质心不重合,那么继续执行 2 步骤,直到质心不在发生偏移为止。

- 在 2-3 过程中,需要记录本轮质心偏移过程中,每个样本点被统计的频数。

- 记录本轮计算得到的质心以及该簇下每个点被统计的频数。

- 如果簇的质心与已经计算出的簇质心距离小于 R,那么需要将两个簇的进行合并。

以上步骤会计算出簇的质心,以及每个簇中统计到数据点的频数。

根据以上结果,进行数据分类:

- 循环每个数据点。

- 对于当前数据点,每个簇都会记录一个关于该点的统计频数,比较每个簇中关于该点的频数,找出频数最大的簇,那么该点就应该划分到这个簇中。

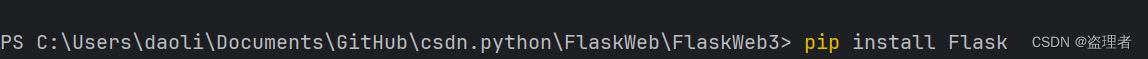

下面是用 Python 实现该算法的示例代码:

import numpy as np

from sklearn.cluster import MeanShift

from sklearn.datasets import make_blobs

# 使用均值漂移法计算分类的质心

def mean_shift(data, radius=2.5):

clusters = []

# 遍历每一个数据

for i in range(len(data)):

# 指定样本数据点就是质心

cluster_centroid = data[i]

# 初始化簇的频率

cluster_frequency = np.zeros(len(data))

# 针对当前点,进行质心漂移

while True:

# 存储在半径范围内所有的数据点

temp_data = []

for j in range(len(data)):

v = data[j]

# 计算点到质心的距离

if np.linalg.norm(v - cluster_centroid) <= radius:

# 添加半径范围内的点

temp_data.append(v)

# 添加数据被统计到的频数

cluster_frequency[j] += 1

old_centroid = cluster_centroid

# 计算每列数据的平均值

cluster_centroid = np.average(temp_data, axis=0)

# 如果新的质心与旧的质心相同,则停止质心漂移

if np.array_equal(old_centroid, cluster_centroid):

break

has_same_cluster = False

# 合并相同的质心

for cluster in clusters:

# 如果新的质心与原有的质心距离小于半径,则合并这两个质心

if np.linalg.norm(cluster["centroid"] - cluster_centroid) <= radius:

has_same_cluster = True

# 合并频数

cluster["frequency"] = cluster["frequency"] + cluster_frequency

break

# 如果不需要合并,则添加新的质心

if not has_same_cluster:

clusters.append({

"centroid": cluster_centroid,

"frequency": cluster_frequency,

})

# 打印分类的个数

print("簇的个数:", len(clusters))

return clusters

# 对所有的数据进行分类

def clustering(data, clusters):

t = []

for cluster in clusters:

cluster["data"] = []

t.append(cluster["frequency"])

t = np.array(t)

for i in range(len(data)):

# 取每个数据被所有分类统计的频次

column_frequency = t[:, i]

# 如果数据被某个分类统计的频次最大,那么该数据应该归为这个分类

cluster_index = np.where(column_frequency == np.max(column_frequency))[

0][0]

clusters[cluster_index]["data"].append(data[i])

# 生成测试的样例数据

X, _ = make_blobs(n_samples=500, cluster_std=0.6)

# 使用现成的库进行分类,得到的质心

ms = MeanShift()

ms.fit(X)

print(ms.cluster_centers_)

# 使用自己实现的 Mean Shift 方法得到的质心

clusters = mean_shift(X)

clustering(X, clusters)

for i in clusters:

print(i["centroid"])

这段代码实现了一个均值漂移(Mean Shift)算法的简化版本,可以用于数据的聚类计算。