【多模态】38、DT-VQA | 专为提升多模态大模型的密集文本场景能力的数据集

文章目录

- 一、背景

- 二、方法

- 2.1 数据来源

- 2.2 数据标注

- 2.3 测评标准

- 2.4 训练策略

- 三、效果

- 3.1 定量分析

- 3.2 定性分析

论文:Exploring the Capabilities of Large Multimodal Models on Dense Text

代码:http://github.com/Yuliang-Liu/MultimodalOCR(即将开源)

出处:HUST 华中科技大学

贡献:

- 本文提出了一个大型(170k个图文对儿)的富文本数据集 DT-VQA

- 本文提出了一个新的测评指标:AccANLS

一、背景

密集文本中包含了很多信息,对于信息提取、文本总结、高级搜索、文档分析等任务非常重要

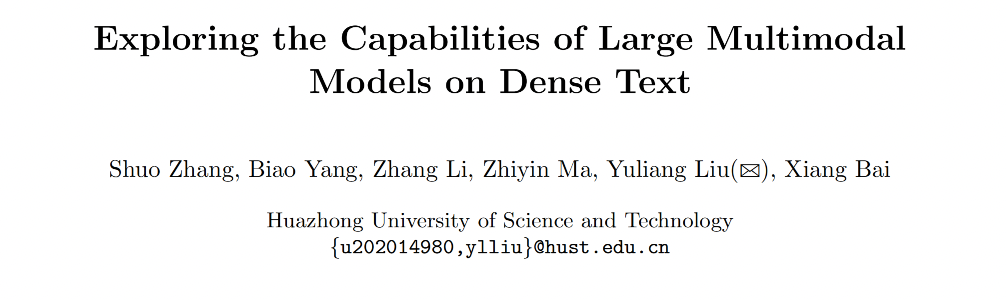

当前的 LMM 方法能够解决很多视觉问题,如图像 caption、视觉问答等,当对于文本相关的视觉任务的表现不是很好,如图 1 所示,很多 LMM 方法都难以回答正确,作者认为这可能是由于输入的分辨率太低且没有训练到位

为了进一步很好的衡量 LMM 在 text 上的能力,作者提出了一个数据集 DT-VQA (Dense Text Visual Question Answering)

这个数据集包括室外场景、表格、产品标签,来源是 HierText [20]、DAST [33]、POIE [13] 和 TabFact [5] 的图像和部分光学字符识别(OCR)信息

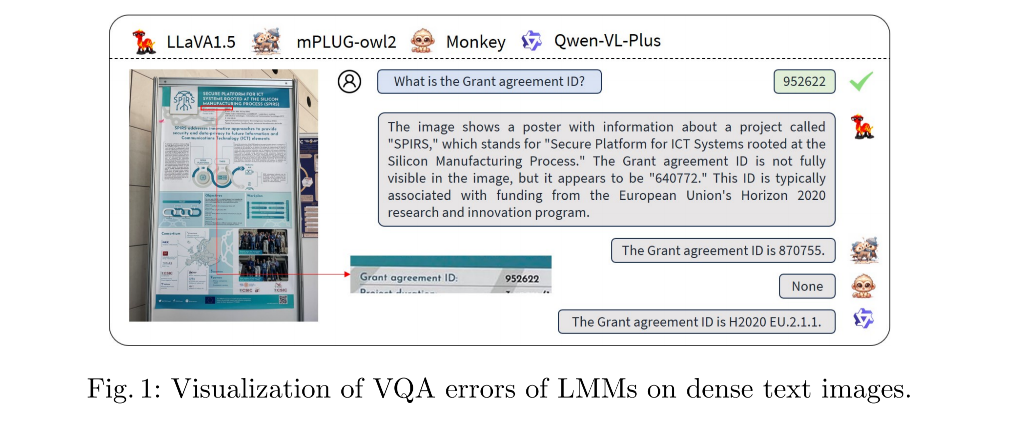

标签生成:借助 Gemini [34] 和 GPT-4V [27] 生成问答对。为 30k 图像获得了 170k 个问答对。

作者设计了 Gemini [34] 和 GPT-4V [27] 的输入提示,以无缝整合图像、OCR 信息和指令,指导生成的问答对与文本相关。

测试集:从 22k 问答对中手动选择了 1.2k 个,而不是随机选择,以确保问题的多样性。

该数据集的特点:

- 高信息密度:文本紧密排列,使得单词区分和边界识别变得困难;

- 复杂布局:图像布局范围广泛,从非结构化场景到半结构化的产品图像和结构化表格;

- 多种文本类型:图像中的字体、大小和排列方式各异,同时还伴有各种噪声,如图像模糊和光照不均。

现有方法在 DT-VQA 上的测试效果:

为了全面评估现有大语言模型(LMMs)的能力,作者在 DT-VQA 数据集上进行了广泛的定量评估和定性分析。实验结果突显了即使是最先进的 LMMs 在处理密集文本图像的复杂性时也面临显著挑战。

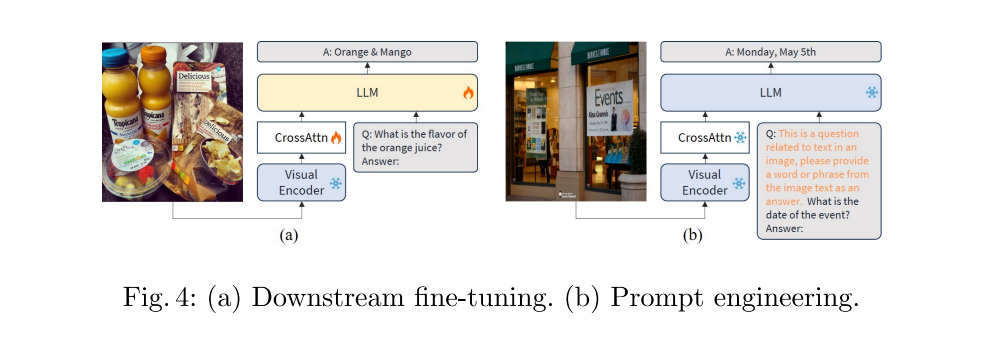

为了解决 LMMs 在处理文本方面的局限性,作者尝试了两种解决方案:提示工程和下游微调。

由于 LMMs 经常生成较长且与图像中存在的文本不直接相关的响应,为了解决这个问题,作者在输入问题之前设计了提示,这显著提高了一些模型在常用指标 ANLS 上的表现。此外,作者提出了一个新的指标 AccANLS,以弥补现有视觉问答(VQA)任务评估的不足。

作者还使用 DT-VQA 训练集对 Qwen-VL [3] 和 Monkey [16] 进行了微调,该训练集由 Gemini [34] 和 GPT-4V [27] 自动标注的问答对组成,结果在测试集上的性能有了显著提升。

文本任务相关数据集介绍:

当前用于富文本图像的数据集,包括 RCTW-17 [29]、COCO-Text [36]、Total-Text [6]、SynthText [8]、CTW1500 [41]、IC15 [11]、MLT [25]、PubLayNet [43] 和 RVL-CDIP [12],主要集中在文本检测和布局分析等基础任务上。

然而,这些基础任务难以满足实际应用中对图像中文本理解和推理的需求。Antol [2] 引入了一个开放的视觉问答(VQA)任务,要求模型基于图像和问题输入提供自然语言的响应。与传统的检测、识别及相关任务相比,VQA 任务对模型感知和理解复杂场景的能力提出了更高的要求。

现有的 VQA 数据集可以根据其应用领域分为通用和特定领域,如面向文本或文档相关。

面向文本的 VQA 数据集,如 OCR-VQA [24]、TextVQA [30]、ST-VQA [4] 和 EST-VQA [37],要求模型通过读取图像中的文本来回答问题。

ChartQA [22] 则引入了与图表设计相关的算术和逻辑推理复杂查询

以文档为中心的数据集如 DocVQA [23]、KLC [31] 和 VisualMRC [32] 则专注于文档图像,强调结构化布局或包含表格。

OCRBench [19] 提出了一个针对各种文本相关视觉任务的综合评估系统,包含 29 个相关数据集。

尽管这些数据集承认了图像中文本信息的重要性,但这些图像中的文本密度并不高。我们引入了 DT-VQA 数据集,专门设计用于解决高密度文本需求,涵盖多种风格,如场景、产品标签和表格。

二、方法

2.1 数据来源

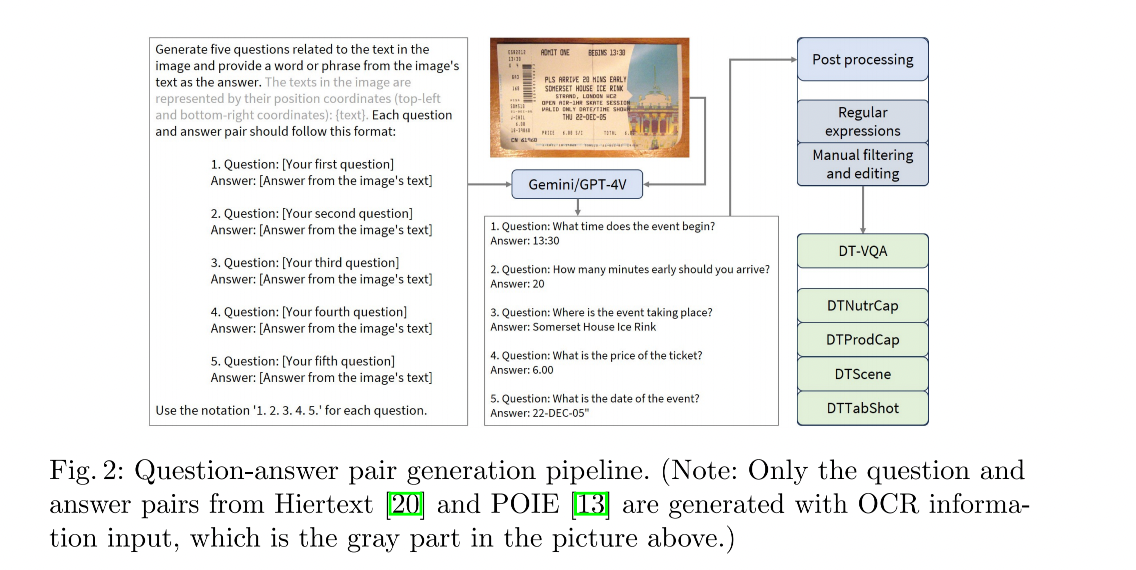

DT-VQA 最终包含 30k 图像,共 170k image-text pairs

数据来源:Hiertext、POIE、DAST、TabFact

2.2 数据标注

数据标注是由 Gemini 和 GPT-4V 完成的,作者将图像、 OCR 信息、指导生成的指令输入到这两个大语言模型中,为每张图像生成五个问答对,然后整理并手动筛选测试集中获得的问答对。流程如图 2 所示。

1、指令设计

由于图像来源多样且标注方法各异,作者将图像大致分为两类:

- 带有文本内容标注的图像(Hiertext [20] 和 POIE [13]):仅使用图像来引导 Gemini [34] 生成问答对

- 不带文本内容标注的图像(DAST [33] 和 TabFact [5]):尽量利用现有的标注信息,将文本和位置信息输入 Gemini [34],以生成更多与文本相关的问答对。准确的文本输入还提高了生成答案的精确度,减少了由于 Gemini [34] 和 GPT-4V [27] 可能出现的文本识别错误而导致低质量问答对的概率。

在 promot 中使用 ”[Answer from the image’s text]” 能够导模型生成与文本相关的问题并从图像文本中提取答案。

对于来自这四个数据集的所有图像,使用 Gemini [34] 为每张图像生成五个问答对。此外由于场景图像的复杂性,额外使用 GPT-4V [27] 对 HierText [20] 训练集(包含 8k 图像)进行另一轮问答对生成。

2、后处理

对于由 Gemini [34] 和 GPT-4V [27] 生成的初始响应:

- 首先使用正则表达式提取问答对

- 所有测试集图像都缺乏原始文本标注。为了确保测试集问答对的质量,会进行人工筛选,并为每种风格的图像选择 300 个高质量的问答对

- 对于测试集中引起疑问的答案,会进行进一步处理。例如,考虑到答案“2g”,类似“2 g”、“2 grams”和“2”都可以被认为是正确的。因此手动将原始单一答案逐一转换为潜在答案列表。对于每个评估指标,从这个列表中选择得分最高的答案。

3、统计分析

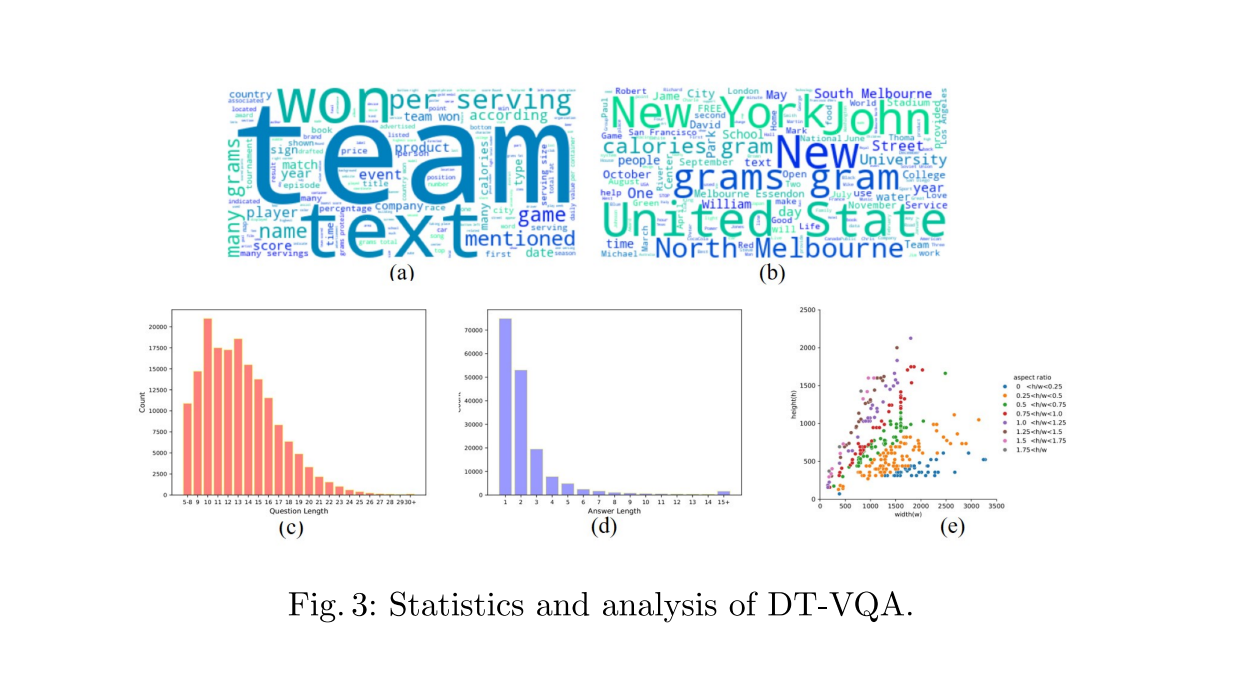

作者分别分析了数据集中问题和答案中的词频,并以词云的形式展示它们。

- 图 3(a) 对应于问题中不同词语的频率,揭示了“team”这个词在问题中出现频率最高。这归因于 TabFact 数据集主要记录了各种团队的信息,导致 Gemini 为 TabFact 生成的问题中频繁出现“team”一词。

- 图 3(b) 表示答案中不同词语的频率,其中高频词大多包括地名或单位名称,显示出相对均匀的分布,并表明在回应不同问题时具有良好的多样性。

- 在图 3© 和 (d) 中,展示了数据集中问题和答案长度的分布。横轴表示问题或答案中的单词数量,纵轴表示每种长度的出现频率。问题通常由至少五个单词组成,大多数问题的长度在 10 到 15 个单词之间。答案长度集中在 1 到 3 个单词范围内,强调简洁的回应。在少数情况下,Gemini 生成的答案可能超过20个单词。这一分析表明我们数据集中问题和答案长度分布合理,与基于密集文本的问题回答要求很好地契合。

- 图 3(e) 随机选择了所有使用图像中的400张,并以散点图形式展示它们的尺寸。图像的纵横比落在合理范围内,没有出现过宽或过高的图像。而且偶尔会有纵横比较大的图像,这增加了数据的多样性。

2.3 测评标准

与选择题答案的确定性评分不同,评估开放式问题回答的准确性存在一定的挑战。作者使用三个指标来评分答案。

1、ANLS(平均归一化 Levenshtein 相似度)[4]:

ANLS 是一种基于 Levenshtein 距离的相似度度量方法,用于评估生成答案与参考答案之间的相似性。Levenshtein 距离,也称为编辑距离,是指将一个字符串转换成另一个字符串所需的最小编辑操作数(包括插入、删除或替换一个字符)。

- 容错性:ANLS 通过计算生成答案与参考答案之间的 Levenshtein 距离,并将其归一化,可以在文本识别有轻微偏差的情况下施加轻微惩罚,从而提供一定的容错能力。例如,如果生成答案与参考答案只有一个字符的差异,ANLS 仍然可以给出较高的相似度得分。

- 细粒度评估:ANLS 可以量化生成答案与参考答案之间的部分匹配程度,而不仅仅是完全匹配或完全不匹配。

问题:

- 过长输出的敏感性:当大语言模型(LMMs)无法准确确定生成答案的预期长度时,可能会生成过长的答案。这种情况下,ANLS 的结果可能无法有效反映答案的正确性和模型的性能。例如,一个包含正确答案但附带大量无关内容的长回答,其 ANLS 得分可能会显著降低。

- 阈值问题:使用默认阈值0.5,如果 NLS 值低于0.5,则认为答案不正确,得分为0。这意味着即使生成答案与参考答案非常接近,但略低于阈值,仍然会被判定为不正确。

2、Acc 准确率:

准确率是评估生成答案是否包含正确答案的一种二元指标。当生成答案完全匹配参考答案时,记为正确。也就是当预测的文本都能在参考文本中找到时,得分为 1,否则得分为 0。

完全一致(Exact Match)指的是生成的答案与参考答案在字符、词语和顺序上完全相同。换句话说,两个字符串必须逐字符地一模一样,没有任何差异。

优点:

- 简单直接:准确率只考虑生成答案是否包含正确答案,是一种二元指标。当生成答案完全匹配参考答案时,记为正确,非常直观。

- 易于理解和实现:准确率计算简单,不需要复杂的相似度计算,因此易于理解和实现。

问题:

- 忽略部分匹配:准确率只考虑完全匹配情况,对于部分匹配或接近正确但有细微差异的情况,准确率不会给予任何分数。例如,如果参考答案是“2g”,而生成答案是“2 grams”,尽管两者含义相同,但准确率会认为这是不正确的。

- 对长回答的不敏感性:由于准确率只检查正确答案是否出现在输出中,它对包含正确答案但附带大量无关内容的长回答不敏感。这意味着一个包含正确答案但附带大量无关内容的长回答仍然会被认为是正确的。

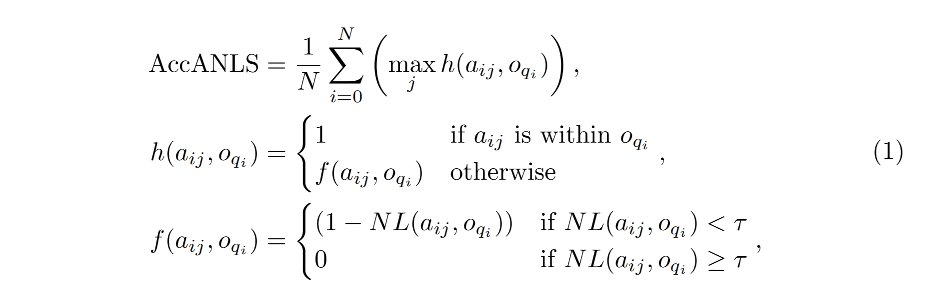

3、AccANLS:

AccANLS 是结合了准确率和 ANLS 的综合评估指标,用于平衡文本识别错误和输出长度过长的问题。AccANLS 是作者新引入的一种新颖评估标准,也就是根据指示函数来确定使用 Acc 评估还是使用 ANLS 评估。

AccANLS 的计算步骤如下:

- 对于每个问答对,首先检查生成答案是否完全匹配参考答案。如果匹配,则准确率为1,此时 AccANLS 得分也为1。

- 如果生成答案与参考答案不完全匹配,则计算它们之间的 ANLS 值。

- 最终得分取决于上述两个步骤:

- 如果准确率为1,则 AccANLS 得分为1。

- 如果准确率不为1,则使用 ANLS 方法计算得分。

特点:

- 综合性:结合了准确率和 ANLS 的优点,更全面地评估模型性能。

- 容错性和简洁性:既考虑了文本识别误差,也避免了过长输出带来的问题。

计算公式如下

i

i

i:第 i 个问题j

j

j:第 j 个参考答案- NL:

a

i

j

a_{ij}

aij 和o

q

i

o_{qi}

oqi 之间的归一化编辑距离 t

a

o

tao

tao:阈值

示例:

假设有一个问题“苹果是什么颜色的?”,参考答案是“红色”。以下是不同情况下 AccANLS 的处理方式:

情况1:完全匹配

生成答案:“红色”

准确率:1

AccANLS:1

情况2:部分匹配

生成答案:“红色苹果”

准确率:0(不完全匹配)

NLS:“红色苹果”与“红色”的归一化 Levenshtein 相似度较高(假设为0.8)

AccANLS:(1 – 0.2) = 0.8

情况3:过长输出

生成答案:“红色苹果很好吃”

准确率:0(不完全匹配)

NLS:“红色苹果很好吃”与“红色”的归一化 Levenshtein 相似度较低(假设为0.4)

AccANLS:(由于低于阈值0.5)= 0

通过这种方式,AccANLS 能够更全面、公平地评估开放式问题回答任务中的模型性能。

2.4 训练策略

作者选择了两个训练策略在 QWen-VL 进行实验:downstream fine-tune、prompt engineering

1、prompt engineering

鉴于应用于各种日常场景的最终目标,大语言模型(LMMs)通常在图像描述和各种视觉问答(VQA)格式等多样化任务上进行训练。在训练过程中,针对不同预期答案长度提供特定的指令。

因此,在没有额外提示的情况下,LMMs 无法自主准确确定预期答案的长度。如第4.1节所述,LMMs 在 VQA 任务中经常生成过长的答案,使得 ANLS 评估方法失效。

为了解决这个问题,作者在问题开头引入了一个额外的提示文本:“这是一个与图像中文本相关的问题,请提供一个来自图像文本的单词或短语作为答案。”这一修改使模型能够生成较短格式的答案,并更多地关注图像中的文本信息。

2、finetune

考虑到密集文本数据集带来的挑战,作者使用 DT-VQA 数据集对 Qwen-VL [3] 和 Monkey [16] 进行了微调。

鉴于 DAST 数据集中的图像包含大量中文图像,而 Gemini 生成的问答对混合了中文和英文,这可能不利于训练 LMM 正确从图像中提取文本以回答问题,所以排除了 DAST,只使用 DTScene、DTNutrCap 和 DTTabShot 中的问答对进行微调。

三、效果

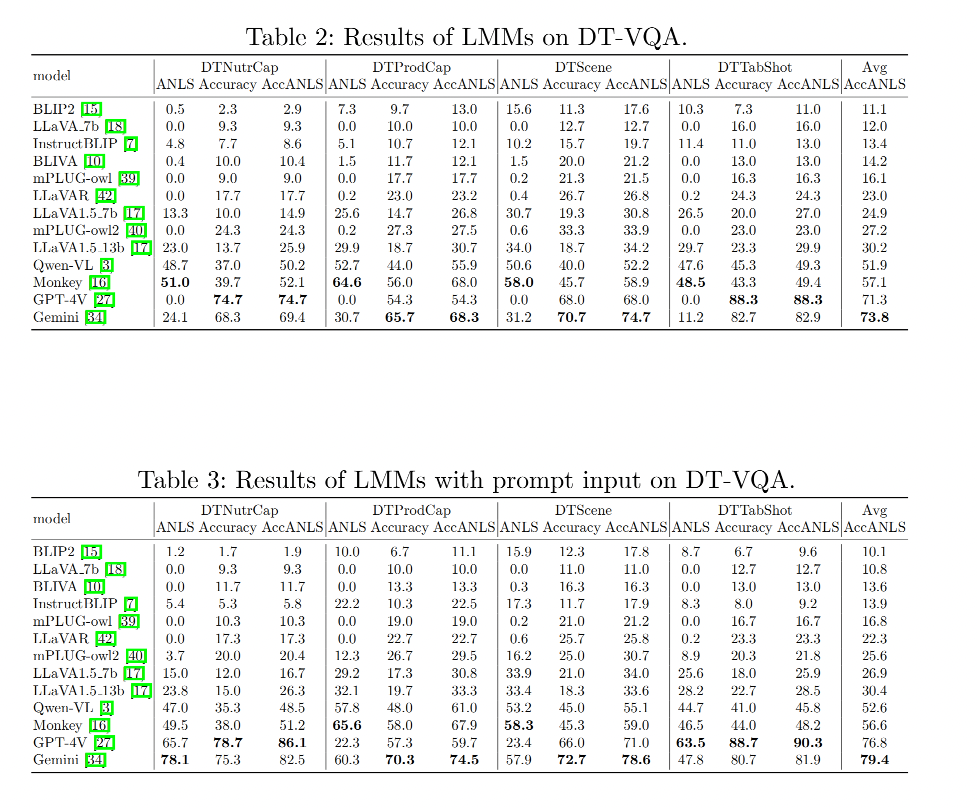

3.1 定量分析

ANLS与准确率的对比:

- 大语言模型(LMMs)在ANLS上的平均得分显著低于准确率,表明生成过长输出是一个显著问题。

- AccANLS指标考虑了文本识别错误和输出长度问题,相对于单独的ANLS或准确率指标,能更全面地反映模型的能力。所以在整个测试集中使用AccANLS进行排名。

提示词的影响:

对于一些模型,添加提示词后,ANLS得分显著提高,如InstructBLIP [7] 和 GPT-4V [27],表明这些模型对指令有较强的遵从性。

一些模型如Monkey [16]在添加额外提示词后,AccANLS得分略有下降。这可能是因为该模型在训练期间已经足够关注文本部分,不再需要额外提示词。为每个模型设计更合适的提示词是一个需要进一步探索的问题。

不同数据集上的表现:

LMMs在DTNutrCap和DTProdCap上的得分相对较低,而在DTScene和DTTabShot上的得分相对较高。这表明模型在处理表格和场景文本图像中的稀疏文本时表现较好,但在处理过于紧凑和密集的文本图像时面临挑战。

开源模型的表现:

除了GPT-4V [27] 和 Gemini [34] 之外,在开源模型中,Qwen-VL [3] 和 Monkey [16] 表现最好。这在一定程度上表明,提高输入图像分辨率对密集文本图像的识别和理解有显著贡献。

GPT-4V 和 Gemini 的表现:

考虑到Gemini [34] 在生成测试集问答对时提供了帮助,它预计会取得高分。此外,即使添加了额外提示词,GPT-4V [27] 也仅获得76.8分。

在开源模型中,表现最好的Monkey [16] 仅获得56.6分。LMMs 的性能仍有很大的提升空间,这证明了引入专门为密集文本问答设计的数据集的重要性。

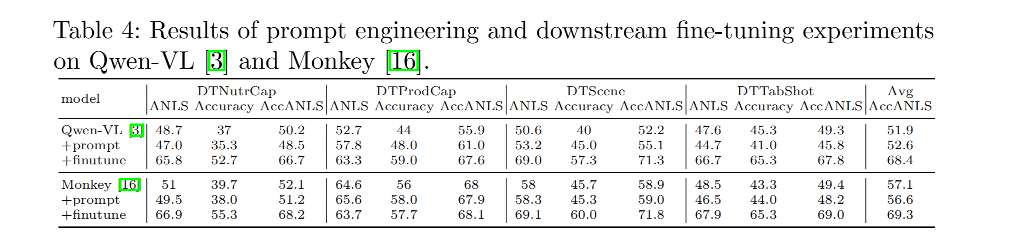

由于 QWen-VL 和 Monkey 开源,所以作者在这两个模型上分别进行了 prompt engineering 和 finetune,如表 4 所示

仅仅在问题中添加提示词对这两个模型并没有显示出显著的改进,这可能是因为这些模型本身就能辨别 DT-VQA 任务需要从图像的文本内容中生成简短答案的要求。

但是在 DT-VQA 训练集上进行微调后,这两个模型都表现出显著的提升,这表明即使数据是自动标注的,模型的性能也可以显著增强。

3.2 定性分析

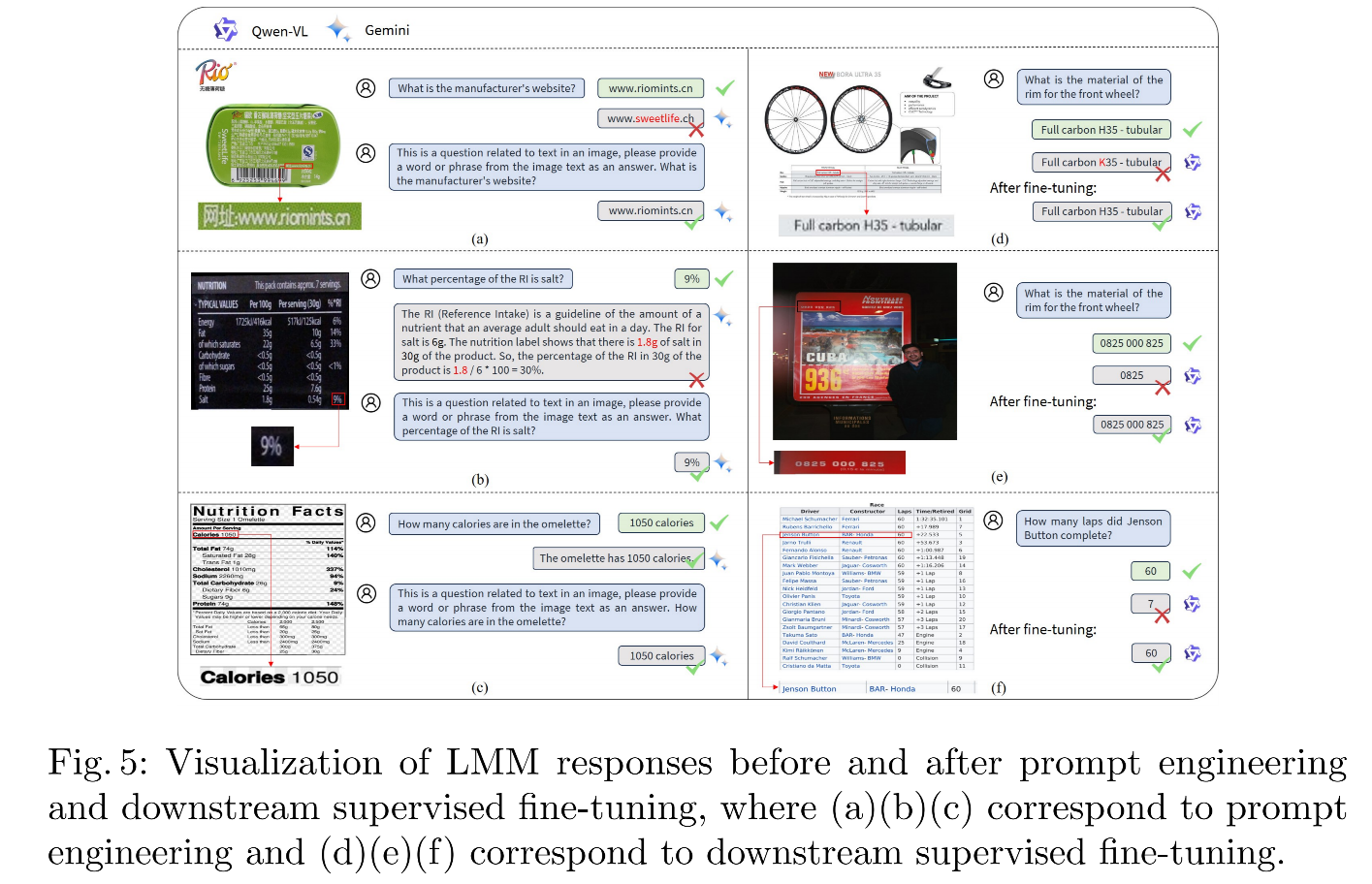

图 5 展示了使用 prompt engineering 和 finetune 前后的对比

1、prompt engineering

当 prompt 中使用 “这是一个与图像中文本相关的问题” 和 “从图像文本中提取答案” 时,能够有效地引导大语言模型(LMMs)更多地关注图像中的文本内容,提高了文本识别的准确性。

例如,在图 5(a) 中,Gemini [34] 最初正确理解了问题并识别了相应的答案位置;然而,由于识别错误,它提供了错误的答案。

在应用提示语后,它给出了正确的答案。这可能归因于 LMM 被要求利用图像中的文本来回答问题,从而减少了来自图像其他特征和模型预先存在的语言和世界知识的干扰。

提示语中的短语 “请提供一个单词或短语” 要求 LMM 输出简短的答案,在某种程度上解决了过长输出导致的幻觉问题,如图 5(b) 所示。此外,包含提示语使得答案长度更短,提高了 ANLS [4] 评估方法的可信度,如图 5© 所示。

2、finetune

对比 Qwen-VL [3] 在 DT-VQA 数据集上微调前后的答案,模型在微调后文本识别能力有所提升,如图 5(d) 所示。

此外,微调过程增强了模型对图像布局的理解。在图 5(e) 中,微调后的模型准确地提供了完整的电话号码作为答案,而在图 5(f) 中,它不再因为理解表格的挑战而生成错误的响应。这突显了引入多样化密集文本图像的有效性,可能提高模型在文本相关场景中的表现。